依赖环境:Scala

Spark是使用Scala编写的,用Scala编写Spark任务可以像操作本地集合对象一样操作分布式数据集RDD

安装的过程可以参考我的这篇文章Scala安装

安装完scala可以查看版本

scala -version

这里重点介绍Spark的安装,相比于hadoop的安装要简单一些,而且步骤类似,话不多说,开始!

Spark的安装

解压

tar -zxvf /spark-2.2.2-bin-hadoop2.7.tgzmv spark-2.4.2-bin-hadoop2.7 spark-2.4.2

修改环境变量

#spark

export SPARK_HOME=/opt/hadoop/spark-2.4.2

export PATH=$PATH:$SPARK_HOME/bin

重新加载环境

source /etc/profile

修改配置文件

mv spark-env.sh.template spark-env.sh

vim spark-env.sh

export SPARK_MASTER_IP=master

export SCALA_HOME=/opt/hadoop/scala-2.12.8

export SPARK_WORKER_MEMORY=6g

export JAVA_HOME=/opt/java/jdk1.8.0_201

export HADOOP_HOME=/opt/hadoop/hadoop-2.8.0/

export HADOOP_CONF_DIR=/opt/hadoop/hadoop-2.8.0/etc/hadoop

配置spark从节点,修改slaves文件

cp slaves.template slaves

修改为

slave1

slave2

将文件传到两个从节点上

scp -r spark-2.4.2 root@slave1:/opt/hadoop/

scp -r spark-2.4.2 root@slave2:/opt/hadoop/

在将salve1与slave2的spark环境添加即可

在bin目录下输入

./spark-shell

可进入脚本环境

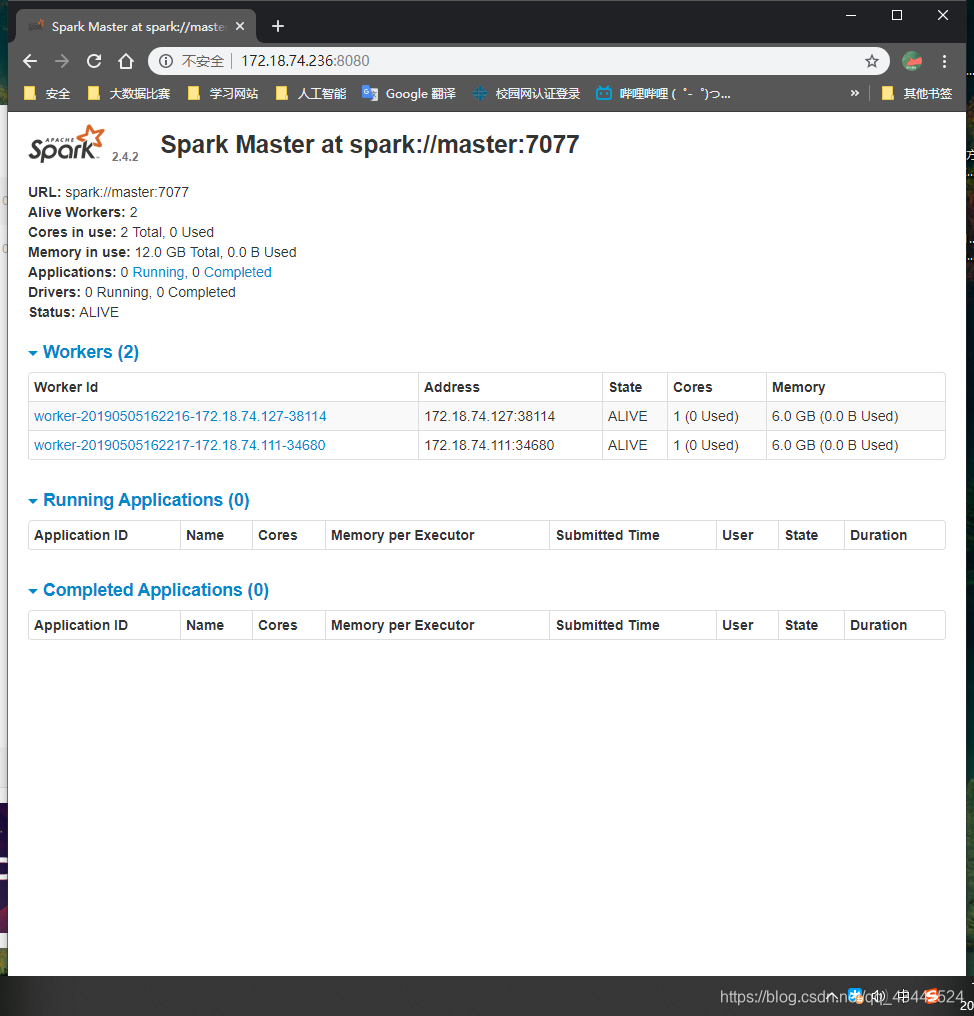

在浏览器输入IP地址:8080

Spark目录

bin包含用来和Spark交互的可执行文件,如Spark shell。

core,Streaming,python,…包含主要组件的源代码。

example包含一些单机SparkJob,你可以研究和运行这些例子。