zookeeper集群安装

在master,slave1,slave2上安装

hadoop用户进入master

cd /opt/hadoop/

tar -zxvf zookeeper-3.4.8.tar.gz

vim /etc/profile

#zookeeper

export ZOOKEEPER_HOME=/opt/hadoop/zookeeper-3.4.8

export PATH=$ZOOKEEPER_HOME/bin:$PATH

cd zookeeper-3.4.8/conf

cp zoo_sample.cfg zoo.cfg

修改配置文件 zoo.cfg

# The number of milliseconds of each tick

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

dataDir=/opt/hadoop/zookeeper-3.4.8/data

dataLogDir=/opt/hadoop/zookeeper-3.4.8/logs

# the port at which the clients will connect

clientPort=2181

# the maximum number of client connections.

# increase this if you need to handle more clients

#maxClientCnxns=60

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

#

# http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

# The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

#autopurge.purgeInterval=1

#写入节点ip与端口

server.4=master:2888:3888

server.2=slave1:2888:3888

server.3=slave2:2888:3888

保存退出

cd /opt/hadoop/zookeeper-3.4.8

mkdir data

mkdir logs

cd data

vim myid

4

保存退出

将zookeeper文件传到salve1与slave2中

scp -r zooker-3.4.8 root@slave1:/opt/hadoop/

scp -r zooker-3.4.8 root@slave2:/opt/hadoop/

在salve1与slave2中分别将myid修改为2 3

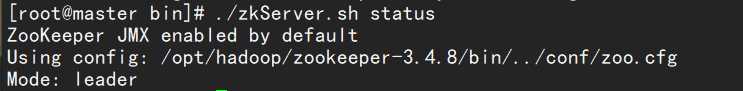

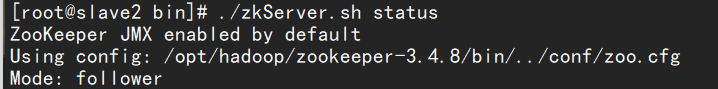

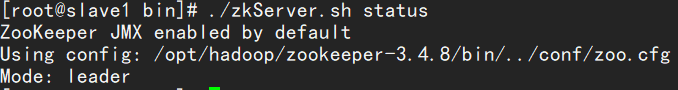

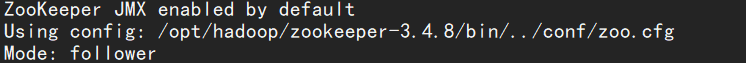

在bin目录下

./zkServer.sh start

./zkServer.sh status

./zkServer.sh start-foreground

zookeeper启动不了可以使用该命令查看报错

问题:为什么master不是leader

先以一个简单的例子来说明zookeeper整个选举的过程:

假设有五台服务器组成的zookeeper集群,它们的id从1-5(对应的是zoo.cfg中的server.serverID值,同时对应myid文件的值)

同时它们都是最新启动的,也就是没有历史数据,在存放数据量这一点上,都是一样的.假设这些服务器依序启动,来看看会发生什么.

1) 服务器1启动,此时只有它一台服务器启动了,它发出去的信息没有任何响应,所以它的选举状态一直是LOOKING状态

2) 服务器2启动,它与最开始启动的服务器1进行通信,互相交换自己的选举结果,由于两者都没有历史数据,所以id值较大的服务器2胜出,但是由于没有达到超过半数以上的服务器都同意选举它(这个例子中的半数以上是3),所以服务器1,2还是继续保持LOOKING状态.

注:每台zookeeper服务器启动时都是先选举自己然后再去对比ID值

3) 服务器3启动,根据前面的理论分析,服务器3成为服务器1,2,3中的老大,而与上面不同的是,此时有三台服务器选举了它,所以它成为了这次选举的leader.

4) 服务器4启动,根据前面的分析,理论上服务器4应该是服务器1,2,3,4中最大的,但是由于前面已经有半数以上的服务器选举了服务器3,所以它只能接收当小弟的命了.

5) 服务器5启动,同4一样,当小弟.

总结:从以上的例子可以看出leader的选举不仅跟ID的大小有关系,还跟启动的顺序有关系,因为ID的值越大而且还第一个启动,那它就可以被选举为leader。

现在大家就应该清楚如何自定义leader了,只要把你想要自定义为leader机器的ID值设置比其他的值都要大,并且先启动你要自定义leader的机器,这样就可以自定义成功了。

自定义过程中有可能会出现的问题:

按照以上的做法去操作但是想要自定义的机器没有变为leader却是follower,原因是因为在你启动自定义机器时它还没有完全启动成功就启动了其他的机器,这样等自定义机器启动完之后其余的机器已经选好了leader,所以就只能成为follower。又或者自定义机器启动失败也会造成以上原因

将master的值修改为4后